※2024年5月14日にChatGPT4oが公開され、生成スピードが向上しました。よって、この記事で書かれているスピードに関してはすでに解決されたと言えます。

最近の生成AIの進歩は目まぐるしいですよね。よく生成AIに試験問題を解かせて合格できるのか、という実験をやってる人がいます。今回はそれを真似て第1種放射線取扱主任者試験を何割解けるのかを検証してみました。

※国家試験は誰かがやっていたのを見たことがあるので

※放射線取扱主任者は国家試験を控えた学生が目指すべき資格の一つです。技師免許を取得するための国家試験よりも難しいので、受験するべきか悩む人も多いと思います。それについては以下の記事もあわせて読んでください。

学習用アプリの紹介

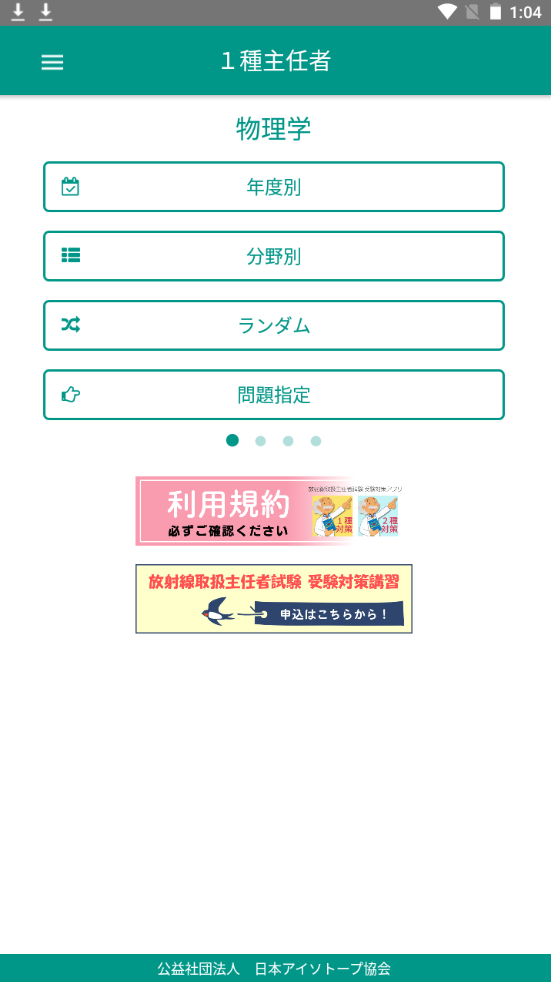

主任者試験の過去問と解答が必要なのですが、今回はアイソトープ協会が提供している学習用アプリを使っていこうと思います。ついでに、このアプリについて紹介しておきます。

このアプリは無料で使えるので、これから受験する人はぜひご活用ください。iOSでもAndroidでも使えます。

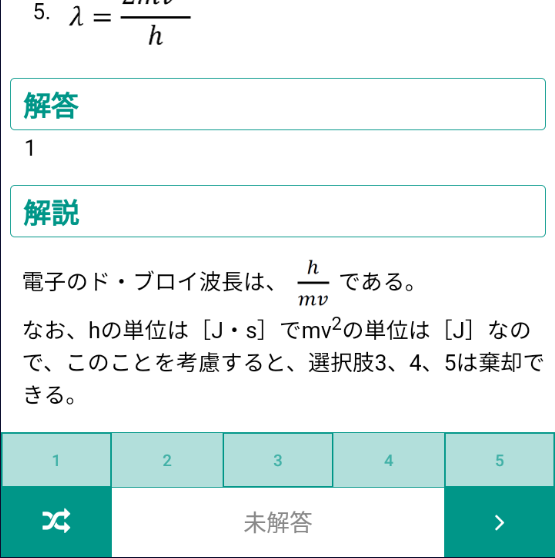

インターフェースはこんな感じです。

出題方法は「年度別」・「分野別」・「ランダム」・「問題指定」です。物理学と書いてあるところの近くを左右にフリップすると他の科目に切り替えられます。管理測定、実務が無いのは残念なところです。

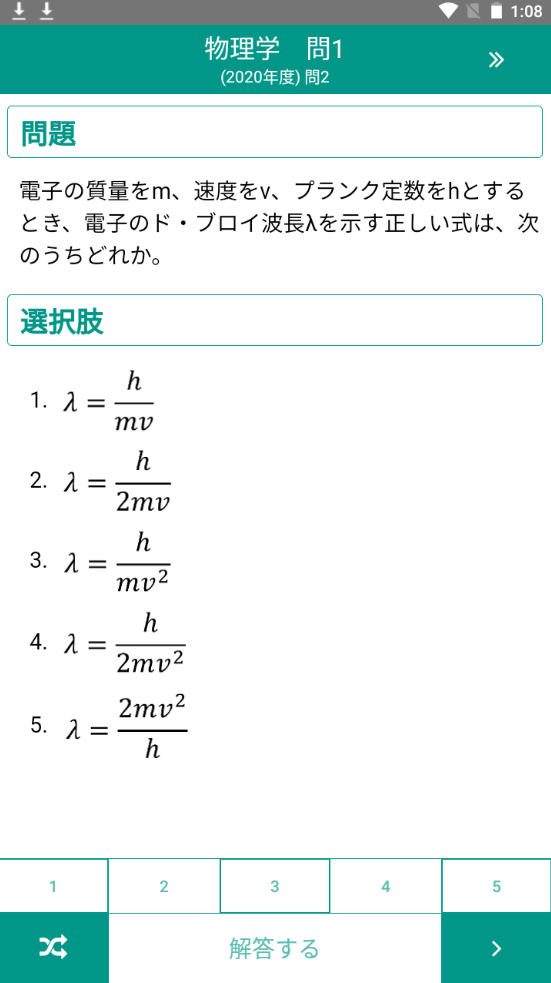

問題を解いている途中の画面は以下のような感じです。

なかなか見やすくていいですね。解答するを押すとすぐに答えと解説が表示されます。

隙間時間の試験勉強にいいですね。

ちなみに、2024/4/8の時点で評価☆4.4、ダウンロード数5000+となっています。

検証の条件

今回はアプリが提供してる「物理学」・「化学」・「生物学」・「法令」の4科目を対象にしてランダム出題で20問(合計80問)を対象としました。ただし、図が含まれる問題は対象外としました。

ChatGPTには以下のような形で質問しました。

以下の問題を解いてください。回答は選択肢より1つだけ選んでください。

~~~~以下、問題文~~~~~

試行回数は2回として正答率の平均を求めました。1巡目と2巡目は新規(New chat)で別々に質問しました。なお、検証はChatGPT4.0と3.5の2パターンで行いました。特別なプラグインは使用していなく初期条件としました。

答えが1つしかないのに2つ回答した場合や、解なしと答えた場合は不正解としました。

また、1巡目と2巡目が回答である割合(再現性)も求めました。

計算的には 再現性=(1巡目と2巡目の回答が同じ数)/回答数 という式で求めました。

結果:正答率と再現性

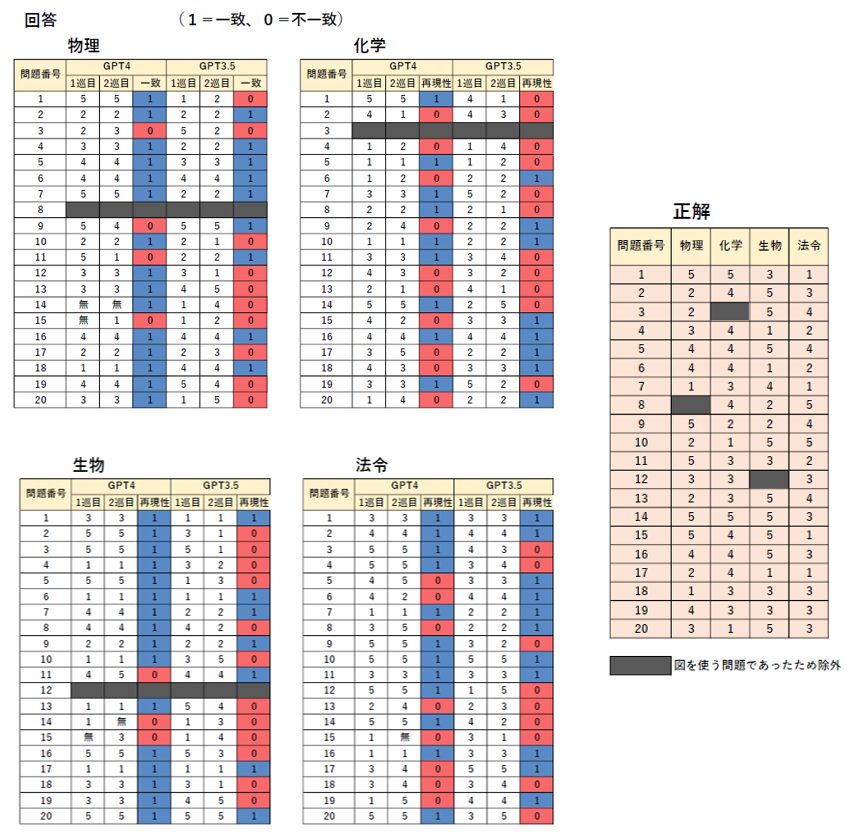

結果は下の通りになりました。

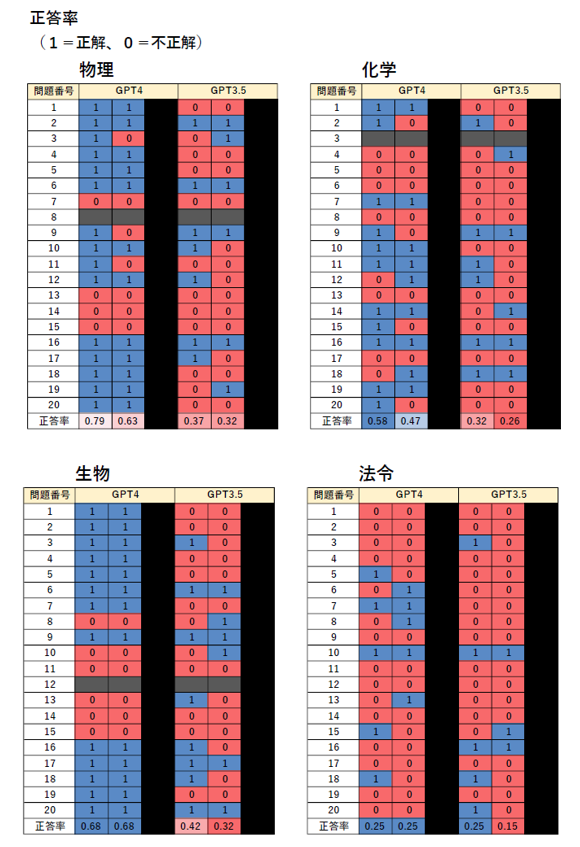

また、正答率は以下のようになりました。

この結果から

正答率は・・・

■物理

GPT4:(0.79+0.63) / 2 = 0.71 (71%)

GPT3.5:(0.37+0.32) / 2 = 0.35 (35%)

■化学

GPT4:(0.58+0.47) / 2 = 0.53 (53%)

GPT3.5:(0.32+0.26) / 2 = 0.29 (29%)

■生物

GPT4:(0.68+0.68) / 2 = 0.68 (68%)

GPT3.5:(0.42+0.32) / 2 = 0.37 (37%)

■法令

GPT4:(0.25+0.25) / 2 = 0.25 (25%)

GPT3.5:(0.25+0.15) / 2 = 0.20 (20%)

となり、合格基準(>50%)となるのは

GPT4だと物理、化学、生物

GPT3.5だとなし

だと分かりました。

有料のGPT4がGPT3.5よりも性能が良いのは予想できましたが、GPT4なら合格、GPT3.5なら不合格と明確に線引きされました。

法令に関してはGPT4であっても苦手なようですね。日本に限った内容であることが多く、AIが学習する機会が少ないのかもしれません。

また、化学も物理・生物より成績が劣りましたので、少し苦手なのかもしれません。

再現性は・・・

★物理

GPT4:0.79 (79%)

GPT3.5:0.47 (47%)

★化学

GPT4:0.47 (47%)

GPT3.5:0.42 (42%)

★生物

GPT4:0.84 (84%)

GPT3.5:0.37 (37%)

★法令

GPT4:0.60 (60%)

GPT3.5:0.55 (55%)

という結果になりました。正答率が高いGPT4はGPT3.5よりも再現性が高く、複数回質問しても同じ回答である割合が高いことが分かりました。

GPT4の物理・生物は再現性が高く、AIが自信をもって回答をしていることが分かります。一方で、化学は物理・生物よりも低くなっており、聞くたびに答えが変わりがちです。実際、GPT4は何度も計算をやり直したりして自信がないような振る舞いが多かったです。

これらの結果から正答率が高い科目ほど再現性が高いということが予測されます。

が、法令に関しては再現性がある程度高いにも関わらず正答率が低かったです。これは確信して(自信ありげに)、間違っているということになりますので困ります。学習の情報量が少ないため迷うことはないが、正解もしないといった感じでしょうか。

GPT4はGPT3.5に比べて3~5倍くらい回答に時間を要しました。時には回答が不適だと判断して計算しなおしたり、解がないといった回答をしたり・・・。

ただ、この問題に関しては日本語のChatGPTの高速化が図られるとのことでしたので(2024/4/18時点)、この問題はいずれ解決していくでしょう。

まとめ

GPT4では物理・化学・生物に関しては合格する基準(>50%)の正答率でした。ただ法令に関しては現状、使い物にならないことが分かりました。(化学も少し苦手?)

GPT3.5では合格は無理ですね。

想定よりもGPT4とGPT3.5に差があるんだなぁという印象です。

課金するだけの価値はありそうです。ただし、GPT4は単位時間中の質問数の上限に達しやすいことや、回答が遅いといった欠点もあります。

今回は文字を入力してChatGPTに質問しましたが、画像を入力にして文字を読み取ってもらうという検討も面白いと思います。その場合は図が含まれる問題も対応できると思います。

取扱主任者の試験監督の方はしっかりとカンニング防止に努めていただかないと、合格者が続出してしまいますね。

正答率が高い科目ほど再現性が高いという傾向が見られたので、複数回質問して得られた回答の変動から信頼性を予測できる可能性もありますね。

以上、検証でした!